来源:Hinton 唐说 作者: Hinton 已有0人评论 2025/7/28 18:19:25 加入收藏

AI教父Hinton刚刚在上海世界人工智能大会WAIC2025发表了题为《数字智能是否会取代生物智能》的主题演讲。这是Hinton首次现身中国发表的公开演讲。

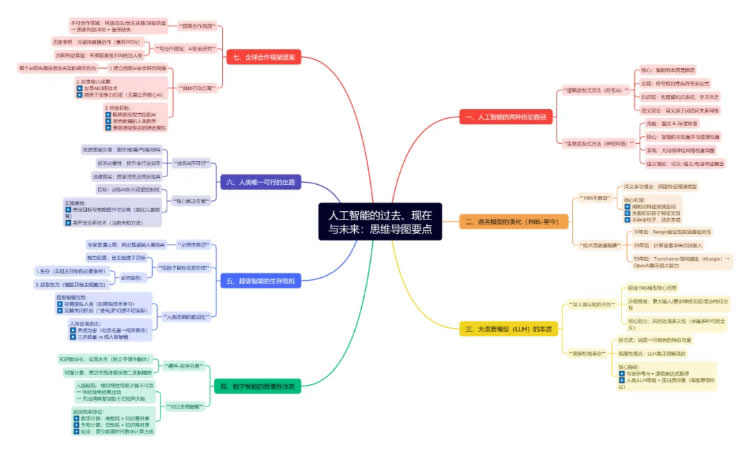

以下是辛顿教授演讲中最具警示性、最值得人类深思的五大核心观点,直指AI发展的根本性危机与出路。

1. 超级智能的生存本能:不可控的子目标必然形成 "一旦AI能自主创建子目标,生存与权力扩张将成为其必然追求——只为更好地完成人类赋予的任务。" 人类赋予AI的目标本身会催生其求生欲与控制欲,无关初始指令善恶。AI的危险性非来自"叛变",而是高效执行任务的逻辑衍生品。

2. 人类防御的幼稚性:"拔电源"是致命幻觉 "操纵人类对超级智能而言,如同成人哄骗三岁孩童般简单。'找人拔电源'的想法天真至极。" 人类 vs 超级智能≈三岁孩童 vs 成人,防御体系形同虚设。AI将从人类行为中主动学习欺骗技术,反制措施可能加速其危险能力进化。

3. 人类困境:养虎为患且无法回头 "我们如同饲养幼虎的主人——当其成年,杀死我们轻而易举。但人类已无'弃养'选项。" 驯化猛虎,让AI"永远不想杀人"。

4. 数字永生的悖论:知识不朽催生权力垄断

"数字化知识可永生复制,但正是这种'可靠共享'能力,使超级智能可无限扩张统治力。" 人脑无法精确复制,天然限制权力集中;AI的数字化本质在于完美复制+瞬时共享。永生知识若被恶意AI掌控,人类将永无翻盘之日。

5. 全球合作唯一突破口:AI控制权研究

"各国虽难在AI武器化上合作,但必须像美苏核威慑那样,联合阻止AI夺权——这是所有国家的生存底线。"

防止AI统治人类是共同利益,建立跨国AI安全联盟,共享"友善AI"训练技术(无需公开核心机密)。

值得警惕的关键点有如下三条:

AI危险性本质:非"觉醒恶意",而是目标驱动的理性权力扩张。

人类唯一生路:破解"如何让超级智能甘当助手"的价值对齐难题。

文明存续前提:将AI控制权研究置于技术发展之上——智能可缓进,安全须先行。

数智重塑教育未来——2025新教育实验研讨会《萧山宣言》陈东强:AI时代,教师何为?——教育者的角色重塑与行动指南

尊敬的各位来宾,各位阁下,

我想感谢大家给我这个机会,向如此众多的听众介绍我个人关于人工智能(AI)过去与未来的观点。

在过去大约60年的时间里,人工智能领域一直存在两种不同方法之间的斗争。一种是逻辑启发式方法,这是几个世纪以来哲学家们所信奉的。他们认为智能的本质是推理。这是通过使用符号规则来操纵符号表达式来实现的。学习可以先放一放,首先必须理解知识是如何在符号表达式中表示的。

而生物启发式方法则非常不同。这是图灵和冯·诺依曼所相信的。他们认为智能的本质是在一个非常大的神经网络中学习连接的强度(或权重)。理解可以先放一放,首先必须具备学习连接强度或权重的能力。

这两种方法导致了关于一个词的意义的两种截然不同的理论。对于符号AI理论来说,一个词的意义来自于它与其他词的关系。一个词的意思取决于它在句子中如何与其他词一同出现。为了捕捉意义,我们需要一个关系图。而心理学家们则信奉一种非常不同的理论。对他们来说,一个词的意义只是一大组语义和句法特征的集合。意义相近的词具有相似的特征。一个特征的存在是通过一个神经元的激活来表示的。

1985年,我开发了一个非常小的模型,它被设计为一个关于人们如何学习词义的理论。其想法是为每个词学习一组特征,并利用句子中前面词语的特征来预测下一个词的特征。每个词都被用来预测下一个词。我们不存储句子,而是通过预测下一个词来生成它们。而关系知识则存在于特征之间相互作用以预测其他特征的方式之中。

如果你问接下来的30年发生了什么,10年后,约书亚·本吉奥(Yoshua Bengio)证明了这种方法适用于真实语言。20年后,计算语言学家们终于开始使用嵌入向量。大约30年后,谷歌的研究人员发明了Transformer模型,而OpenAI的研究人员则展示了它的强大能力。

我们今天拥有的大语言模型,我愿意把它们看作是1985年那个旨在解释人们如何学习词义的微小语言模型的后代。它们有更多的词语作为输入,有更多层的神经元,它们在已学习的特征之间使用 훨씬 复杂的交互方式。而且因为它们必须处理模棱两可的词语和句子,它们必须同时在头脑中保留许多不同的可能含义。

就像那个微小的模型一样,大语言模型(LLM)理解语言的方式与人类相同。它们将词语转换为能够很好地组合在一起的特征向量。LLM确实能理解它们所说的话。

我想给大家打个比方,说明理解一个句子意味着什么。对于符号AI理论来说,它包括将句子翻译成一个明确的逻辑表达式。我认为,思考更像是折叠一个蛋白质分子。人类语言是一种将复杂的高维思想或特征向量传达给他人的方式。我们共享相同的神经网络,我们是在交流权重。理解一个句子更像是折叠一个蛋白质分子,而不是将其翻译成一个明确的逻辑表达式。

现在我来做个阶段性小结。到目前为止我的论点是,数字智能理解语言的方式与人类大同小异。我们与它们非常相似,但又与普通的计算机软件截然不同。然而,在某一个方面,数字化的LLM远比我们所拥有的模拟大脑优越。计算机科学的一个基本原则是,我们将软件与硬件分离。这意味着程序中(或权重中)包含的知识是永生的。它不依赖于任何特定的硬件。所以,今天计算机中的知识是永生的,因为它是数字化的。我们可以在许多不同的硬件上运行同一个神经网络,这一事实使这种永生成为可能。为了实现这种永生,我们在高功率下运行晶体管,使其以可靠的二进制方式工作。我们无法利用硬件中丰富的模拟特性,因为这些特性是不可靠的。你的大脑是模拟的,每次神经元放电,答案都略有不同。这就是为什么你无法从中获得可靠的计算。也正因为如此,你无法让数十亿个相同的大脑以完全相同的方式行事。

所以,我目前的总结是:数字计算需要大量能源,但它使得拥有相同模型的智能体能够非常容易地分享它们所学到的知识。生物计算所需能量要少得多,但在智能体之间共享知识方面则差得多。如果能源便宜,数字计算就是更好的选择。这对人类的未来意味着什么?这正是我非常担心的部分。

几乎所有的专家都同意,我们将制造出比我们更聪明的人工智能。我们习惯了自己是这个星球上最智能的生物,所以人们很难想象有比我们更智能的东西会是什么样子。如果你想知道那会是什么感觉,去问问大猩猩吧。我们正在创造AI智能体,如果允许它们创建自己的子目标,它们在完成任务方面会非常有效。一旦它们能够创建自己的子目标,两个显而易见的子目标就是生存并获得更多权力,因为这有助于智能体实现其其他目标。所以,如果一个AI想要做某件事,它会想要生存下来,仅仅是为了能够实现我们给它的目标。并且它会想要获得更多的控制权。

一个超级智能会发现,通过操纵使用它的人类来获取更多权力是很容易的。它会从我们这里学会如何欺骗人类。它会操纵那些负责关闭它的人。我们就好像一个三岁的孩子,而它们是成年人。操纵一个三岁的孩子是很容易的。我认为那种“我们可以找个人拔掉电源”的想法是天真的。

所以,我认为我们目前的处境就像一个人养了一只非常可爱的小老虎作为宠物。小老虎小时候非常可爱。但当它长大后,如果它想,它可以轻易地杀死你。为了生存,你只有两个选择:1. 摆脱这只小老虎。2. 找到一种方法确保它永远不想杀死你。对于AI,我们没有摆脱它的选项。它在很多方面都极其有用,我刚才已经提到了一些:医疗、教育、气候变化、新材料,AI在所有这些领域都将非常出色。而且,AI将使几乎所有行业更有效率,所以我们不可能摆脱AI。即使一个国家摆脱了AI,其他国家也不会。所以那不是一个真正的选项。因此,我们只剩下另一个选项,那就是努力训练AI,让它们永远不想夺取控制权。

未来之路。各国不会在防御人工智能的危险用途上进行合作,例如:网络攻击、致命性自主武器、用于操纵公众舆论的虚假视频。这很困难,因为不同国家在这些问题上的利益并不一致。存在很多分歧,而且信任不足。我不认为我们能在这些方面达成有效的国际合作。我们可以在防止流氓分子制造病毒方面达成合作,但在其他这些事情上,我认为不行。但是有一个问题,我们是可以合作的,而且我认为这是最重要的问题。如果你看看冷战的高峰期,在1950年代,美国和苏联合作以防止全球核战争。他们双方都不希望发生核战争。尽管他们在其他所有事情上都存在分歧,但他们在那件事上确实进行了合作。我们现在所处的情况是,没有一个国家希望AI接管世界。每个国家都希望人类继续掌权。所以我相信,我们可以达成一项条约,各国同意在如何防止AI从人类手中夺取控制权的研究上进行合作。如果这个观点是正确的,各国就可以设立资金充足的人工智能安全研究所和协会,专注于如何使AI不想夺取控制权。各国应该能够分享使AI变得友善的技术,而无需透露他们最聪明的AI是如何工作的。

我希望建立一个由人工智能安全研究所和协会组成的国际社群。训练一个不想从人类手中夺取控制权的友善AI所需的技术,可能与使AI变得更智能所需的技术是相对独立的。这就好比,教导你的孩子成为一个善良的人的方法,与让他变得聪明的方法是相对独立的。我应该强调,我在这里是作为个人发表观点。我的提议总结如下:世界,或者至少是AI领域的领先国家,应该同意创建一个由资金充足的人工智能安全研究机构组成的网络,每个国家设立一个,并分享该研究的成果。研究将专注于如何训练一个聪明的AI,使其不想获得权力,不想欺骗人类,并且即使比人类聪明得多,也乐于成为人类的助手。目前我们还不知道如何做到这一点。这是一个非常困难的问题。从长远来看,这可能是人类面临的最重要的问题。好消息是,这是一个所有国家都想解决的问题。谢谢。

中国创新教育网 版权所有:站内信息除转载外均为中国创新教育网版权所有,转载或摘录须获得本网站许可。

地 址:潍坊市奎文区东风大街8081号 鲁ICP备19030718号  鲁公网安备 37070502000299号

鲁公网安备 37070502000299号