来源:知识分子 作者: 朱松纯 已有0人评论 2025/2/23 9:37:41 加入收藏

导读:为什么AlphaGo、ChatGPT没有在中国诞生?为什么中国只能出现“百模大战”?·什么时候才能出现人工智能的“中国时刻”?这是朱松纯教授提出的关于人工智能的“中国之问”,在当前通用人工智能(AGI)发展进程中,西方主导的”大数据+大算力+大模型”的模式被认为是唯一正确的发展路径。直到最近中国本土的大模型deepseek的出现才打破了这一根深蒂固的思维定式。北京通用人工智能研究院院长、北京⼤学智能学院院长、北京大学人工智能研究院院长清华⼤学基础科学讲席教授朱松纯在莲花山研究院成立20周年学术思想研讨会和第四届智能计算创新会议上回顾了数据驱动的人工智能研究的起源;2009年之后的技术范式从数据驱动转变为因果与价值驱动的根本原因;更提出了我们要突破西方主导的叙事框架,发展中国特色的AGI道路的关键——基于中国思想、突破单纯的数据驱动转向更综合的范式、构建融合”心”与”理"的通用智能体系、注重人机共生的智能社会构建。

引言:直面人工智能的“中国之问”

2022年底以来,以Chat GPT为代表的大模型进入公众视野,并引发社会广泛的关注。通用人工智能已经超越了纯粹的学术研究层面,成为了国家间科技争夺的前沿焦点。要知道2020年我刚回国时,提出要建立我国第一个通用人工智能研究院,那时还有人觉得谈通用人工智能太遥远,仅仅4年后的现在,很多人又觉得通用人工智能可以马上实现。资本和流量挤进这个热门赛道,声称他们已经“超英赶美”,故意激化国内的“百模大战”……要么冒进,要么悲观,就像很多人对通用人工智能的摇摆一样。作为人工智能领域学者,我觉得自己有责任去做一个解释说明,帮助大家去伪存真,让人们能够看到真实的通用人工智能。

《国家创新驱动发展战略纲要》指出,我国到2050年要建成世界科技创新强国,成为世界主要科学中心和创新高地。中国人能否在人工智能领域建立自主的、原创的独立思想和流派,关系到能不能在人工智能的前沿科技中抢占制高点。

每每站在国家命运的十字路口,中国人总会听到来自历史的叩问。无论是“李约瑟难题”“钱学森之问”“杨振宁三问”,还是今天的人工智能“中国之问”,都考验着我们国家战略方向的确立和科学家的使命感。我想,要交出一份满意的答卷,就要走出一条属于我们自己的路,走底层逻辑自主可控的创新之路,走人工智能与人类价值观对齐的创新之路,走不随大流、坚信人工智能的“中国时代”必将到来的创新之路。

2025年春节前夕,中国本土公司的人工智能创业公司,用更低的成本,做出了不逊于国外顶尖大模型的deepseek,就是很好的证明。

这就有必要从源头捋清一条发展脉络,说明我们的先进性。许多成果明明由我们先开始,却被误以为是别人先做出来的。这就像在体育场里跑马拉松经常出现的“套圈”现象,我们已经领先了10圈,其他选手虽然看起来像是在我们前面,实际上却忽略了我们已经远远超越了他们。

所以,我今天讲的故事里,既有我从图像大数据研究这个源头出发,经历人工智能逐渐兴起的经历,也有发现数据驱动人工智能存在巨大局限性的思考;有突破边界,追求价值驱动通用人工智能道路的坚持,还有将“UV理论”应用在建立全球首个AGI评级测试标准的创新尝试。

探源:大数据驱动的人工智能热潮

人工智能现在是全国乃至全世界都关注的热门领域,这种“热度”来自于大语言模型的流行,是在这几年的资本炒作中带来的。但实际上,在这股热潮之外,人工智能已经在科学家们的艰辛探索下,走过了几十年的发展路程。对技术发展溯源,其实也就是对人工智能进行探源,将有助于我们在热闹和喧嚣背后进行清醒思考,并真正理性地选择人工智能的未来之路。

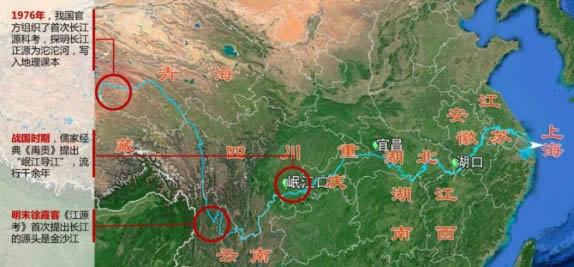

探源是一个非常复杂的问题。以长江为例,儒家经典《禹贡》记载,长江的源头是四川岷江,这种观念持续千年,直到明末徐霞客才通过探源并在《江源考》中提出,金沙江是长江的源头。我国科考队在1976年,才论证了长江源是沱沱河和唐古拉山。历史证明,尽管明代没有地图和导航,尽管科考要冒着风险、付出超乎寻常的代价,人们却着迷于追求源头对人类带来非凡意义。

图1 对数据的溯源就像对长江探源的过程,探索源头能够让我们了解事物的历史、本源,帮助我们更好地理解现在、展望未来

所以,我今天的报告是想追溯大数据的起源,做一次“数据溯源”的科学考察。首先,此处说的大数据尤其指在计算机视觉领域的数据,也就是图像数据。为什么要从视觉说起呢?视觉是“五感”中接收信息量最丰富、系统最复杂、范围最广阔的觉知能力,人的大脑皮层的活动,大约70%是在处理视觉相关信息。我和团队也是从视觉大数据开始,在技术创新的路上艰难突进,才走到今天,所以视觉大数据是我们的起点,是我们的“初心”。

其次,我希望大家能够记得几个时间节点:20世纪70年代、1999年、2001年、2003年、2004年,我还希望大家能记住几个简单的词:PG0、PG+和PG++。这些关键时间发生的几件大事,值得铭记,这几个关键词代表了我与团队探索智能极限、不断迈向通用人工智能的过程。下面我为大家展开讲一讲。

实现通用人工智能是全人类的梦想。要完成这个目标,有三个可以称为哲学层面的问题需要回答:

到底多“通用”才算是通用人工智能? 通用人工智能需要完成多少项任务? 如何评估智能体的进步?

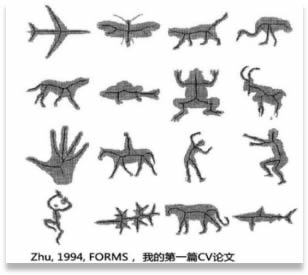

我从20世纪60年代到80年代期间说起。那时陆续出现了基于视觉的人工智能研究,但限于当时的条件,缺乏有效的数据支持。60年代早期研究中使用的线图是由采样人员手绘的。到了70年代,这些线图被用于帮助理解和判断物品。即使到了1994年,技术也没有本质上变革,对于视觉数据的收集依然不尽人意。

图2 1990s年代,2D形状的表达与物体识别解译 (朱松纯 1994)

当我开始筹备我的第一篇关于计算机视觉的论文时,那时候是在做关于2D形状的对称中轴(media axis)表达,我们从明信片、拍照或书籍中扫描照片,然后手工将其转化为二维照片来研究。研究团队想建立一个叶子数据库,需要我们去捡大量叶子进行扫描。那时我常在波士顿的路上边捡叶子,有一次捡得太专注,直到被近处一声呼喊吓了一跳,原来我不小心误入了别人的院子,被当作了小偷。

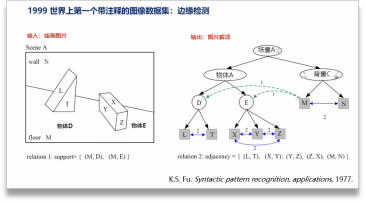

图3 1960-1980年代主要是线画的解释(Line drawing interpretation, Waltz 1960s)和块状物体的解译(傅京孙先生,block world parsing)

这个时期,研究主要是对线画的解释和块状物体的图像解译。傅京孙先生构建了这类研究方法。输入线画图像就会出现线画解译图(Parse Graph,简称PG),在结果中不仅能展示物体本身,还能标注物体之间的关系,例如“连接关系”“遮挡关系”等。

那时候对图像的分析只能用线图表示,图像数据非常匮乏。为什么没有数据呢?我认为主要有两个原因:第一个原因是那时候的计算机资源有限。那时候的微机的速度只有640K,这是什么概念呢?现在手机拍一张照片也有好几兆。手机拍照只要一瞬间,如果用那时的微机处理今天的一张图片,可能就要花很长时间,更不要提处理大数据了。

图4 左图:微机的内存只有640K;右图:世界上第一只数字摄像头诞生于1975年

第二个原因是那个时候还没有数字照相机。1992年,我所在的哈佛实验室花费25万美元构建了一个图像采集系统。这样的“天价”设备,从带宽、内存等方面仍然无法满足基本要求。即便到了1995年,我所在的实验室给我配置了当时最先进的32兆内存工作站,处理图片依然是个难题。编程时经常要读盘,将中间数据载入并保存下来,系统崩溃、数据丢失仍是家常便饭。可以说,一直到90年代中期,人类的硬件条件和数据条件无法支撑大规模视觉数据研究,视觉研究只能做最简单的几何研究。直到在90年代的末期,感知器技术革命的到来,才带动了大数据和机器学习的蓬勃发展。

90年代末,出现了大量图像集,例如索尔比(Sowerby Image Database,简称SID)和科立尔(CorelDRAW)数据集。一些摄影师还会将自己的作品刻进光盘售卖,我把他们买回来尝试读取、研究,只是那时只有图片,还没有标注, 算不上是数据集。

图5 90年代末,感知器革命带来了大数据处理能力的变化,出现了大量图像集。例如,那时出现的索尔比数据集(Sowerby Dataset)就是其中之一

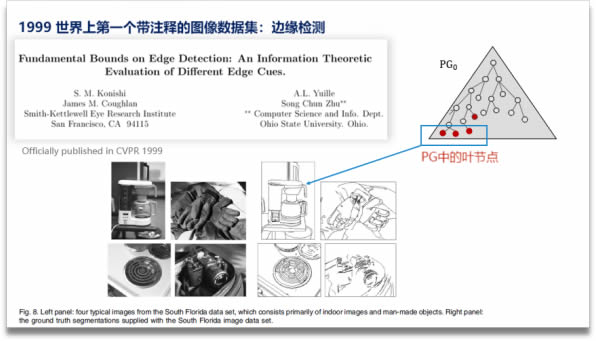

图6 世界上第一次被标注的数据集,正式发表于1999年的CVPR。它的作者是斯科特·小西博士

时间来到了1999年,它的重要性在于,这一年出现了世界上最早的标注数据集。这个标注数据集来自日裔科学家斯科特·小西(Scott Konishi)。他在1998年的研究工作中完成了最早的标注数据集,他的成果后来在论文《边缘检测的基本边界:不同边缘线索的信息论评估》(《Fundamental bounds on edge detection: An information theoretic evaluation of different edge cues》)中有体现,这篇文章是做边缘检测。当时还有一些任务数据集,比如手写体识别,从0到9标十个数字,我认为那是分类,不是标注。

说起来我和小西还有一段故事。那时他是加州大学伯克利分校的博士生,没人带他,就跟了艾伦·尤利(Alan Yullie)做研究。小西博士当时在旧金山一所研究机构里做着枯燥的数据标注工作,经费捉襟见肘。我当时在斯坦福大学当讲师,斯坦福系主任从保罗·艾伦(Paul Allen)那里要到了一笔六万美元的经费(Paul Allen是微软的联合创始人之一)。我正准备辞职,没用完的钱就资助了小西博士,也是第一次用统计的方法来做边缘检测数据集。

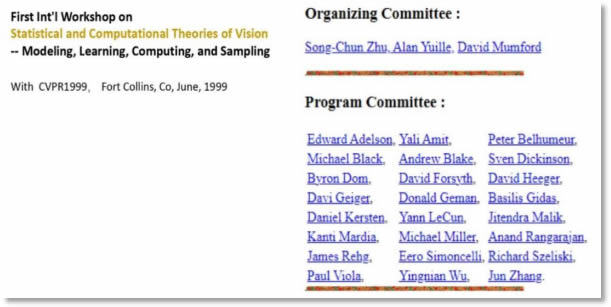

图7 统计建模与随机计算首次进入CVPR。以此为起点,用统计方法来做边缘检测数据集成为一种新的趋势。后来,在我们举办的“首届统计建模与随机计算工作坊”中,来的也多是统计学出身的学者

后来该成果发表在“计算机视觉与模式识别”会议(Conference on Computer Vision and Pattern Recognition,简称CVPR)上,随后我们举办了首届统计建模与随机计算工作坊(First Int'l Workshop on Statistical and Computational Theories of Vision - Modeling, Learning, Computing, and Sampling),来者也多是学统计出身的学者。

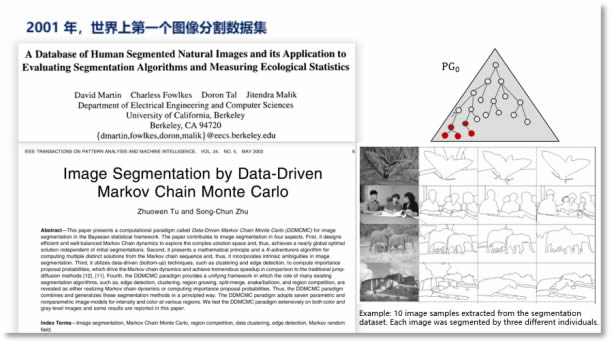

图8 2001年大卫·马丁(David Martin) 提出图片分割(Image Segmentation)数据集,科学家们又向着更高层级图像解析迈出了一步。左下图为屠卓文的论文,意为《数据驱动马尔可夫链蒙特卡罗图像分割》

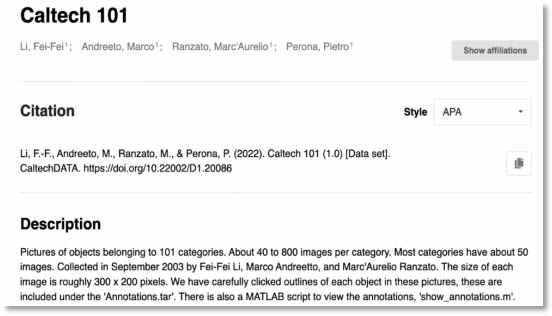

2001年,人工智能的重要时刻又到来了。加州大学伯克利分校的大卫·马丁(David Martin)提出了图像分割(Image Segmentation)数据集。我带的第一个博士生屠卓文在这个数据集上用马尔可夫链蒙特卡洛MCMC方法取得了最佳成绩,远远超过了他们当初提出的算法。2003年,李飞飞提出了Caltech 101数据集,其实这个数据集没有标注,只是包含了包括“狗”“飞机”“汽车”等在内的101个分类。

图9 2003年Li Fei-Fei团队提出Caltech 101数据集,但该数据集没有标注,只是分类

到这里,源头阶段的脉络就很清晰了,此时的我们已经身处“PG时代”。回顾这几个对人工智能来说重要的时间节点,从20世纪70年代到1999年中间跨越了几十年,从1999年到2001年、2003年仅仅只有几年时间,我作为身在这个领域的学者,能够深刻感觉到人工智能发展的“加速度”,成果诞生的时间周期越来越短,“奇点临近”的感受愈发明显,激动人心的未来似乎在向我们招手。

中国创新教育网 版权所有:站内信息除转载外均为中国创新教育网版权所有,转载或摘录须获得本网站许可。

地 址:潍坊市奎文区东风大街8081号 鲁ICP备19030718号  鲁公网安备 37070502000299号

鲁公网安备 37070502000299号